Negli ultimi giorni ho pubblicato alcuni post sul mio profilo Facebook come faccio da sempre: immagini, brevi testi, nessuna call to action esplicita, nessuna domanda studiata per stimolare commenti. Nulla che assomigliasse a un esperimento. Nessuna strategia dichiarata. Stavo semplicemente lavorando, osservando, condividendo.

A un certo punto, però, ho iniziato a guardare le statistiche. E lì qualcosa ha iniziato a stonare, in senso buono.

6 Milioni di Copie Senza Amazon

Sotto il gesso

Innesco affettivo

ChatGPT Look Studio — Registrazione completa del Workshop

Scrivere la storia di una famiglia

Il Metodo Corona

Quando il traffico arriva dai post

Intelligenza pratica

Una nuova corsa all’oro sta nascendo in ChatGPT

NotebookLM Facile

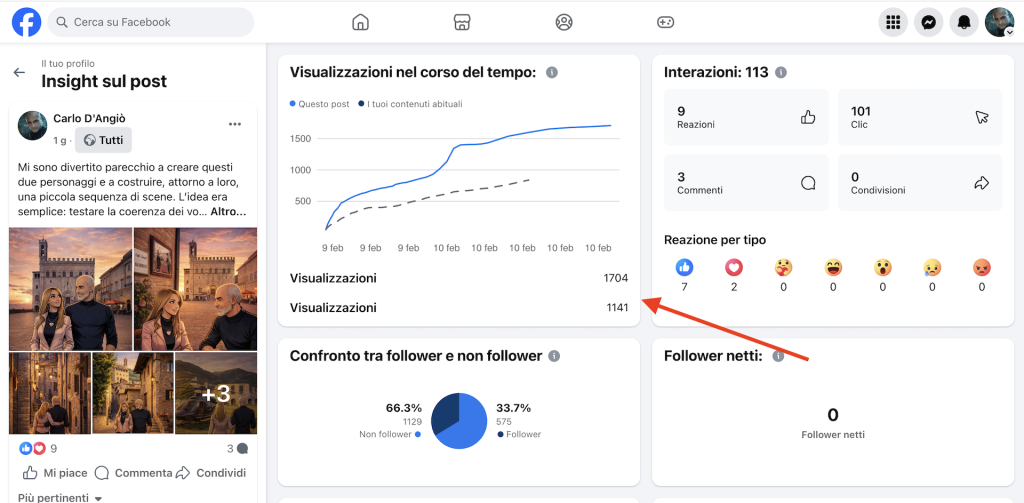

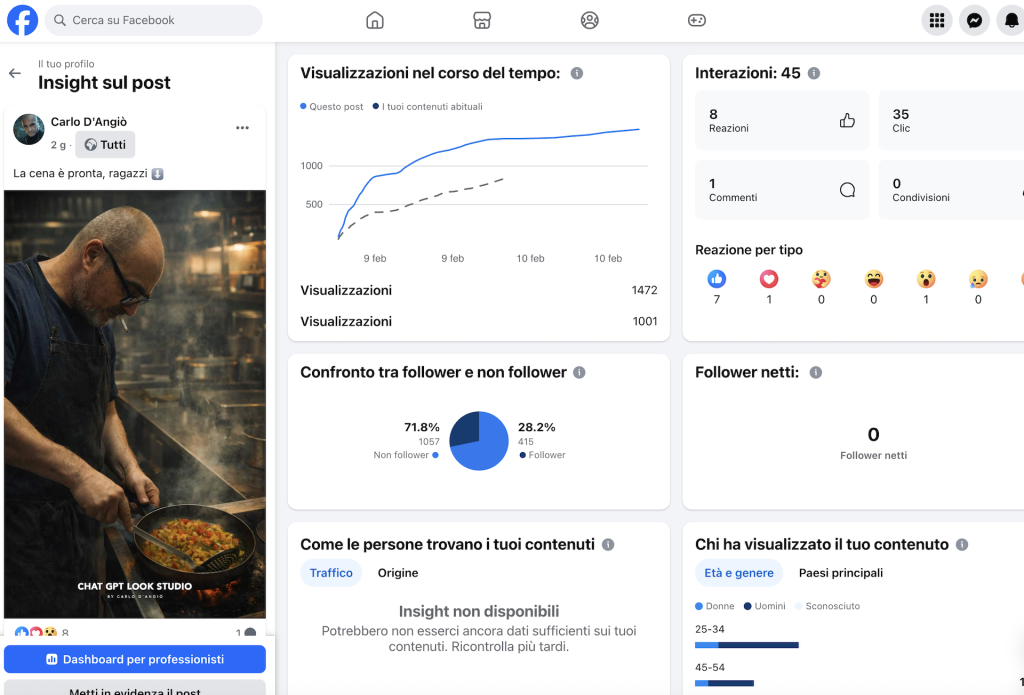

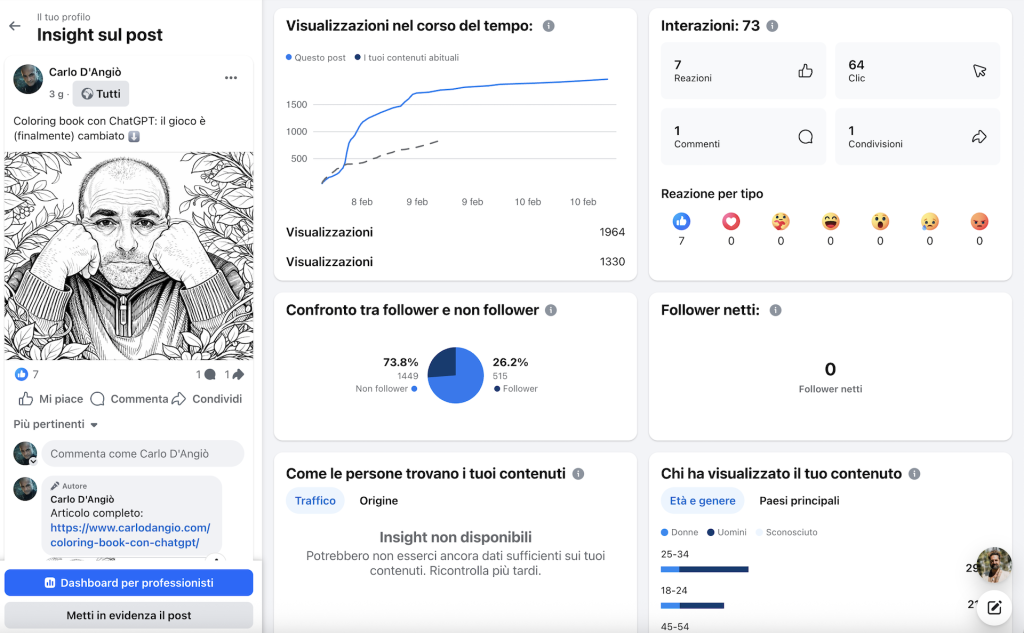

Tre post molto diversi tra loro — una storia illustrata, una scena domestica, un contenuto informativo — stavano mostrando lo stesso comportamento anomalo: più visualizzazioni del solito, molte persone che non mi seguivano, un numero di click sorprendentemente alto… e pochissimi commenti. Non una volta. Tre volte di fila. Con la stessa struttura.

Non era il classico post che “fa parlare”. Era qualcosa di più silenzioso. Le persone si fermavano. Guardavano. Aprivano le immagini. Cliccavano. Poi sparivano. Come se il contenuto avesse fatto il suo lavoro senza chiedere nulla in cambio.

L’unica cosa che quei post avevano davvero in comune era l’immagine. Tutte erano immagini ricostruite con l’intelligenza artificiale. Immagini chiaramente costruite, eppure credibili. Evidentemente artificiali, eppure efficaci.

È stato in quel momento che ho smesso di guardare i numeri come numeri. Perché ciò che stavo osservando non riguardava l’algoritmo, ma la percezione. E riguardava una dinamica che avevo già provato a mettere a fuoco qualche settimana fa, in un piccolo libro intitolato Innesco affettivo.

Cosa dice Innesco affettivo, e perché c’entra con quest’analisi

Innesco affettivo nasceva dalla seguente domanda: perché certe immagini funzionano anche quando sappiamo che sono costruite?

Non mi interessava dimostrare che le immagini “ingannano”. Mi interessava capire in che momento agiscono. E soprattutto prima di cosa.

La tesi centrale del libro è questa: la percezione visiva precede il pensiero razionale. Non come scelta, ma come struttura del nostro funzionamento. Quando un’immagine appare, qualcosa accade prima che possiamo formularlo in parole. Una disposizione, un’apertura, una resistenza. Solo dopo arriva il pensiero consapevole, che spiega, giustifica, razionalizza ciò che è già successo.

Questo è ciò che chiamo innesco affettivo: un’attivazione silenziosa che non decide al posto nostro, ma prepara il terreno su cui ogni valutazione successiva prenderà forma.

Nel libro sottolineo un punto spesso frainteso: sapere che un’immagine è artificiale non ne annulla l’effetto. La consapevolezza arriva dopo. Può commentare l’esperienza, ma non impedirla. È come accorgersi di essere entrati in una stanza già illuminata: puoi chiederti chi abbia acceso la luce, ma intanto la luce c’è.

Questa dinamica diventa evidente quando l’immagine non è usata per stupire, ma per rendere leggibile. Quando non aggiunge significato, ma rimuove interferenze. In quel caso l’immagine non distrae dal contenuto: lo accompagna. Ne riduce l’attrito. Lo rende più facile da attraversare.

Rileggendo oggi quelle pagine alla luce dei dati che sto osservando sui miei post, la connessione è diventata evidente. Le persone stanno entrando in uno spazio percettivo favorevole. L’immagine crea una condizione di attenzione, prima ancora che il testo chieda qualcosa.

Ed è qui che l’analisi smette di riguardare l’AI come tecnologia e inizia a riguardare l’immagine come infrastruttura cognitiva. L’intelligenza artificiale, in questo contesto, non è la causa dell’effetto. È lo strumento che rende possibile una scelta: governare l’innesco invece di subirlo.

Quello che sto osservando nei numeri non è quindi una smentita del libro, ma la sua conferma pratica.

I numeri che mi hanno fatto fermare

Non è stato un numero in particolare a colpirmi. È stata la ripetizione dello stesso comportamento su post diversi.

Guardando le statistiche dei tre contenuti, quello che emergeva non era un picco improvviso o un exploit isolato, ma una traiettoria coerente. Ogni post mostrava più o meno la stessa dinamica, con variazioni minime:

- un numero di visualizzazioni superiore alla mia media abituale

- una distanza costante tra impression e persone raggiunte

- una quota significativa di pubblico non follower

- pochi commenti

- molti click rispetto alle reazioni

In altre parole: le persone vedevano il post più di una volta. Tornavano sull’immagine. La riaprivano. E spesso uscivano da Facebook per approfondire, invece di restare nel feed a commentare.

Questo è il primo segnale che mi ha fatto rallentare l’analisi. Quando le impression superano stabilmente la copertura, non significa che il contenuto “sta girando”. Significa che non viene scartato subito. Viene rivisto. Trattenuto. Riattraversato.

Il secondo segnale è stato il rapporto tra click e commenti. In un ambiente come Facebook siamo abituati a leggere il commento come prova di coinvolgimento. Ma qui il comportamento era diverso: poche parole, quasi nessuna reazione pubblica, eppure molte aperture dell’immagine e diversi click verso l’esterno.

Questo tipo di risposta indica una forma di attenzione silenziosa. Non sociale, non performativa. Un’attenzione che non cerca visibilità, ma continuità. Le persone non sentono il bisogno di dire qualcosa, ma quello di guardare meglio.

Infine, il dato forse più interessante: la percentuale di non follower. In tutti e tre i casi, oltre due terzi delle persone che hanno visto quei post non mi seguono. Questo significa che Facebook sta mostrando quei contenuti fuori dal mio perimetro abituale. E lo sta facendo più volte, non una sola.

Questo tipo di esposizione non viene concessa ai post rumorosi o polemici. Viene concessa ai contenuti che generano tempo di permanenza, riapertura, ritorno. A contenuti che non interrompono il flusso, ma lo rallentano.

A quel punto è diventato chiaro che non stavo osservando una reazione emotiva immediata, ma qualcosa di più strutturale. Non engagement nel senso classico, ma predisposizione. L’immagine sta facendo da anticamera percettiva. Prepara lo spazio. Poi, se il contenuto interessa, il click arrivava. Senza bisogno di commentare.

Ed è stato lì che ho smesso di chiedermi “perché stanno funzionando questi post” e ho iniziato a chiedermi una cosa diversa:

che tipo di esperienza stanno vivendo le persone prima ancora di decidere cosa pensare?

L’unica cosa che hanno in comune

A quel punto ho provato a fare l’unica cosa sensata quando i numeri non tornano: togliere tutto il resto. Ho messo da parte il contenuto dei post. Ho messo da parte il tono. Ho messo da parte il fatto che uno fosse narrativo, uno intimo e uno informativo.

Se li guardi freddamente, quei tre post non hanno nulla che, secondo le regole classiche dei social, dovrebbe farli performare allo stesso modo. Non pongono domande. Non cercano consenso. Non innescano dibattiti. Non promettono ricompense immediate. Non sono “furbi”.

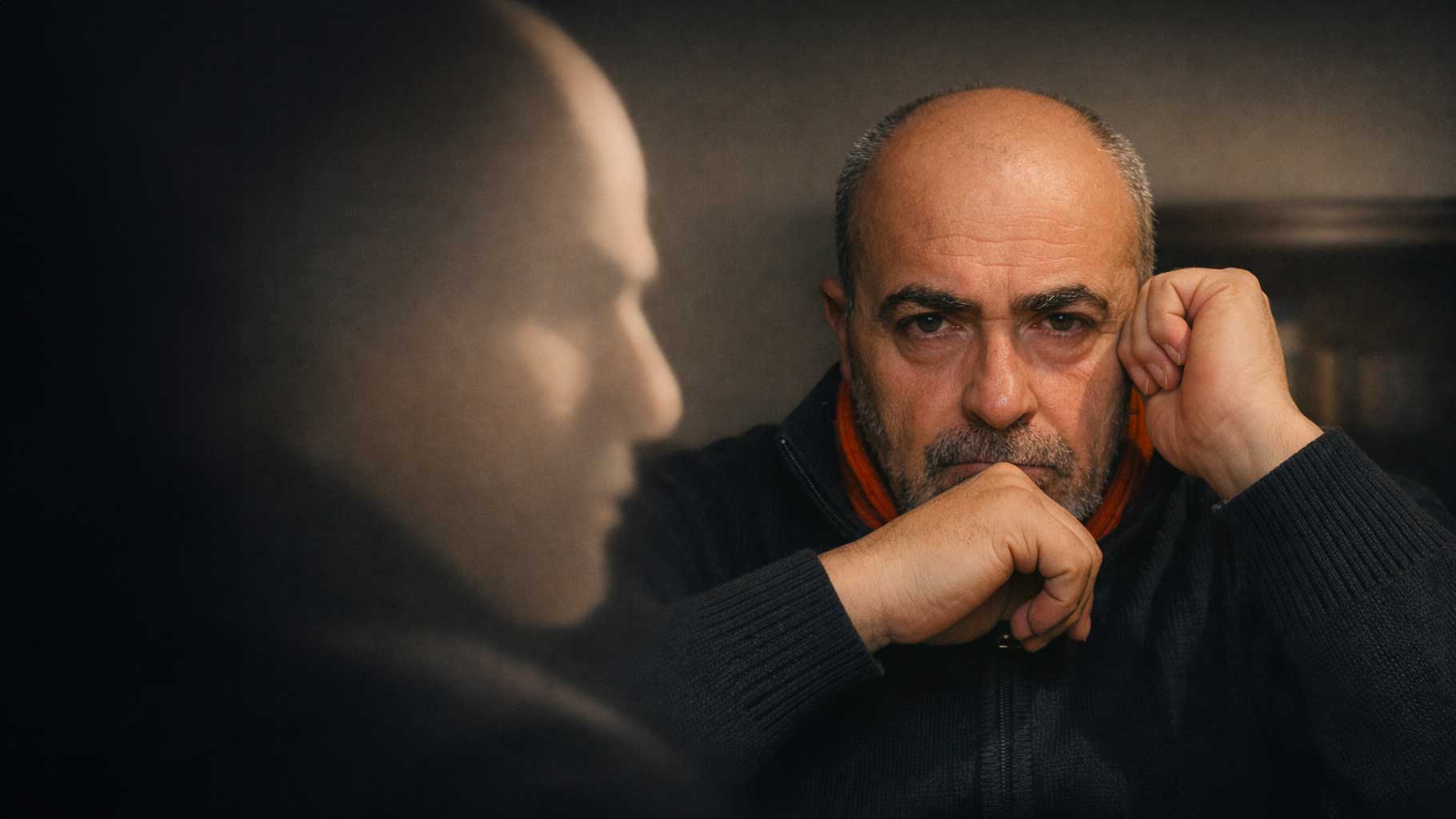

Eppure si comportano allo stesso modo. Resta allora una sola variabile comune: l’immagine. Tutte e tre le immagini sono immagini ricostruite con l’intelligenza artificiale. Non generate dal nulla, non fantasiose, non spettacolari. Ricostruite. Guidate. Registiche. Immagini che partono da una presenza reale e la riposizionano in un contesto più leggibile.

Ed è importante chiarire subito cosa non sto dicendo.

Non sto dicendo che l’AI renda un contenuto più vero.

Non sto dicendo che l’AI “abbellisca” magicamente.

Non sto dicendo che basti usare l’AI per ottenere attenzione.

Sto dicendo una cosa molto più semplice: l’AI ha tolto rumore.

Ha tolto:

- lo sfondo casuale

- la luce penalizzante

- l’incoerenza visiva tra un post e l’altro

- quella quota di distrazione che, normalmente, precede ancora il contenuto

Il risultato non è un’immagine più “bella”, ma un’immagine più facile da attraversare. La mente non deve spendere energia per decifrare il contesto, per capire dove guardare, per ignorare elementi irrilevanti. Tutto è già disposto in modo leggibile.

Ed è qui che accade qualcosa di interessante. Quando il rumore visivo diminuisce, il contenuto non deve più lottare per farsi ascoltare. Non serve alzare la voce. Non serve stimolare reazioni. L’immagine ha già fatto il primo lavoro: ha preparato il terreno.

Il punto decisivo è che questo effetto si produce anche quando l’artificialità è evidente. Le persone non pensano che quelle immagini siano “vere” in senso letterale. Lo sanno che sono costruite. Ma questo sapere arriva dopo. Arriva quando l’immagine ha già orientato l’attenzione.

Ed è esattamente qui che il discorso smette di riguardare l’AI come tecnologia e inizia a riguardare la percezione come processo. Le immagini che ho usato non funzionano perché sono AI. Funzionano perché non lasciano la percezione in balìa del caso. Offrono una struttura. Una soglia di ingresso. Un primo passo che non chiede nulla, ma rende possibile ciò che viene dopo.

Perché queste immagini fermano lo scroll

Il feed di Facebook è diventato un ambiente estremamente prevedibile. La varietà è ormai codificata. Selfie. Foto “professionali” che sembrano stock. Immagini curate, luminose, ben composte, ma già viste mille volte. Caroselli grafici che dichiarano la propria funzione prima ancora di essere letti.

Il cervello, davanti a questo flusso, ha imparato a fare una cosa molto efficiente: classificare in anticipo. La domanda implicita che si attiva è sempre la stessa: “So già cos’è?” Quando la risposta è sì, lo scroll riparte senza attrito. Non perché il contenuto sia brutto o inutile, ma perché è riconoscibile. Appartiene a una categoria nota, già metabolizzata, già archiviata.

Le immagini che ho iniziato a usare negli ultimi post rompono proprio questo automatismo.

Non gridano “sono AI”.

Non gridano “sono arte”.

Non gridano “sono una foto”.

Stanno in una zona intermedia. Una zona che il cervello non classifica immediatamente.

Ed è qui che accade la micro-frattura. Per una frazione di secondo, la risposta alla domanda “So già cos’è?” non arriva. La classificazione si inceppa. Il sistema percettivo è costretto a rallentare. Quel rallentamento è la micro-pausa cognitiva. Non è curiosità consapevole, non è interesse razionale. È una sospensione. Un “aspetta”.

Ed è sufficiente.

In quel tempo minimo — che non viene vissuto come sforzo, ma come attenzione — Facebook registra una cosa fondamentale: tempo di permanenza. Il post non viene scartato. Viene attraversato. A volte rivisto. A volte riaperto.

Questo spiega perché le impression superano la copertura. Perché le persone tornano sull’immagine. Perché il comportamento è silenzioso ma persistente.

Nel linguaggio di Innesco affettivo, è il momento in cui la percezione agisce prima del giudizio. L’immagine non convince, non persuade, non argomenta. Sospende. E in quella sospensione prepara il terreno. In un feed saturo di immagini che chiedono di essere riconosciute, queste immagini funzionano perché chiedono solo di essere guardate un attimo in più.

E oggi, sui social, quell’attimo è tutto.

Autenticità non è casualità

C’è un equivoco che attraversa tutta la discussione sull’intelligenza artificiale e sulle immagini: l’idea che più un’immagine è lasciata al caso, più sia autentica. È un’idea rassicurante, ma falsa.

Nella comunicazione contemporanea l’immagine comunica comunque, anche quando non viene scelta. Comunica lo sfondo. La luce. La postura. Il contesto. Comunica ciò che è marginale almeno quanto ciò che è intenzionale. E lo fa prima che il contenuto abbia la possibilità di dire qualcosa.

Lasciare l’immagine al caso non equivale a “non manipolare”. Equivale a delegare la percezione a una serie di incidenti visivi. Una stanza disordinata, una luce penalizzante, un’inquadratura casuale non sono neutre. Producono un effetto percettivo preciso: trascuratezza, improvvisazione, mancanza di direzione. La mente funziona per scorciatoie. E ciò che vede per primo diventa il contesto di lettura di tutto il resto.

Nel libro parlo di responsabilità dell’immagine proprio per questo motivo. Non perché l’immagine “inganni”, ma perché precede. Non chiede il permesso. Non aspetta che il testo venga letto. Arriva prima e prepara lo spazio.

In questo senso, usare l’AI per ricostruire un’immagine non è un tradimento dell’autenticità. È una scelta di regia. È decidere di non lasciare che elementi accidentali raccontino qualcosa che non ci rappresenta.

Un’immagine costruita che amplifica tratti reali, che rende più leggibile una presenza, che elimina interferenze, non sta fingendo. Sta traducendo. Sta scegliendo cosa rendere visibile e cosa lasciare sullo sfondo. Esattamente come fa ogni forma di comunicazione efficace.

Al contrario, l’idea di autenticità come esposizione grezza produce spesso l’effetto opposto: non maggiore verità, ma maggiore rumore. Il contenuto deve lottare contro una cornice che lo contraddice. Il messaggio arriva già appesantito, già inclinato.

Autenticità non significa rinunciare alla forma. Significa scegliere una forma che non tradisca il senso. E in un contesto in cui l’immagine agisce comunque, rifiutarsi di governarla non è una posizione etica. È solo una rinuncia.

È per questo che oggi diventa decisivo saper governare la creazione delle immagini. E governare non significa affatto “saper usare l’AI”.

Usare uno strumento è una competenza tecnica. Governare un’immagine è una competenza percettiva. Significa sapere quale immagine serve, in quel momento, per quello scopo. Significa scegliere il contesto, il tono, il grado di costruzione necessario affinché l’immagine lavori a favore del messaggio, invece di ostacolarlo o disperderlo.

L’intelligenza artificiale, in questo senso, è solo il mezzo. Ciò che conta è la regia: la capacità di produrre un’immagine adeguata allo scopo per cui viene usata, coerente nel tempo e abitabile dall’identità che rappresenta.

È esattamente su questo passaggio — dalla tecnica alla regia — che nasce ChatGPT Look Studio. Non per insegnare a “fare immagini con l’AI”, ma per imparare a scegliere e governare l’immagine giusta, prima ancora di generarla.

Conclusioni

Quello che ho osservato in questi giorni è che l’immagine lavora comunque, che lo si voglia o no. Lavora prima del testo. Prima dell’intenzione. Prima del giudizio. E prepara il modo in cui tutto ciò che segue verrà attraversato.

I numeri che ho visto non raccontano entusiasmo, né reazioni emotive plateali. Raccontano attenzione. Raccontano tempo. Raccontano ritorno. Raccontano persone che non sentono il bisogno di dire qualcosa, ma che sentono il bisogno di guardare meglio. E questo tipo di risposta non nasce dall’improvvisazione. Nasce quando l’immagine smette di essere un ostacolo.

Le immagini che ho usato non hanno funzionato perché erano spettacolari, né perché erano “furbe”. Hanno funzionato perché non disturbavano. Non chiedevano di essere decifrate. Non costringevano la mente a difendersi dal rumore. Offrivano una soglia di ingresso chiara, leggibile, attraversabile.

In questo quadro, l’intelligenza artificiale è solo ciò che rende possibile una scelta che prima era più costosa, più complessa, più rara: non lasciare l’immagine al caso. Non delegare la prima impressione a una somma di incidenti visivi. Non chiedere al contenuto di combattere contro una cornice che lo tradisce.

Il vero discrimine non è tra immagini vere e immagini artificiali. È tra immagini governate e immagini subite. E se c’è una cosa che questa analisi mi ha confermato è proprio questa: governare l’immagine non significa controllare le persone, ma rispettare il modo in cui la percezione funziona. Significa creare le condizioni perché il contenuto possa arrivare senza dover alzare la voce. Senza dover chiedere attenzione. Senza dover forzare reazioni.

Oggi, quell’attimo in più — quella micro-pausa percettiva — non è un dettaglio. È lo spazio in cui tutto il resto diventa possibile.

0 commenti